Entscheidungen im Qualitätsmanagement auf der Basis von Tendenz- und Risiko-Analysen

Über einen Arbeitsschritt, den man vor Optimierungsmaßnahmen vornehmen sollte

1) Übersicht

Optimierung der Qualität von Produkten und Prozeßabläufen in Wareneinkauf, Fertigung, Montage, Lagerung, Transport und Materialrecycling wird als unverzichtbarer, nicht selten auch als allein erfolgversprechender Schritt zur Stärkung der eigenen Position auf dem Markt angesehen. Optimierung ist ohne Zweifel erstrebenswert.Optimierung umfasst indessen mindestens

- Bestandsaufnahme des jeweils aktuellen, eigenen Potentials, vor allem in Bezug auf das der Konkurrenz,

- Modellierung der relevanten inneren Abläufe,

- mathematisch definierte Optimierungsstrategien, die sich auf Bestandsaufnahme und Modellierung stützen.

Gründlich angegangen ist Optimierung eines Produkts oder eines Prozesses komplex, arbeitsaufwendig, kostenintensiv, die Ergebnisse häufig nicht eindeutig, und diese können in hohem Maß sogar fremdbestimmt sein durch diejenigen, welche gegebenenfalls im Fremdauftrag die Optimierungsschritte modelliert und durchgeführt haben.

Es ist unerlässlich, vor Optimierungsmaßnahmen zu prüfen, ob denkbare Alternativen zu bisherigen inneren Abläufen prinzipiell zu einer Verbesserung führen können. Überflüssig ist es, zu betonen, daß Optimierungsversuche zu früh einsetzen würden, wenn zuvor nicht eindeutig geklärt ist, welche Maßnahmen zur Produktverbesserung überhaupt infrage kommen; denn je größer die Zahl der Parameter ist, welche beispielsweise auf die Fertigung eines Produkts Einfluß nehmen, umso geringer ist die Aussicht, mit Optimierungsmaßnahmen überhaupt ein Optimum zu finden. Mittelständische Unternehmen werden kaum in der Lage sein, komplexen Untersuchungen in irgendeiner Breite zuzustimmen, wenn ihnen nicht eine strenge Vorauswahl der denkbaren Maßnahmen vorangeht; Großunternehmen werden klug genug sein, ausufernden Analysen und ihren Ergebnissen mit Vorsicht zu begegnen.

Wir beginnen hier einen Schritt früher und stellen im folgenden eine alternative Methode vor, die angewendet werden kann, bevor an Optimierungsmaßnahmen gedacht wird: die Frage nämlich, welche Tendenz in Richtung Erfolg oder Misserfolg sich aus Änderungen innerer Abläufe ergeben wird, und mit welchem Risiko solche Änderungen zu bewerten sind, d. h. wie sicher sich eine vorausgesagte Tendenz tatsächlich einstellt. Ist diese Tendenz erkannt und ist sie gesichert, kann untersucht werden, ob sie sogar zu einem eventuell existierenden Optimum des Ablaufs führen wird.

Der vorliegende Beitrag ist wie folgt gegliedert: zuerst eine Einordnung der Tendenz- und Risikoanalyse in das Feld zwischen einfachsten Optimierungsansätzen und Methoden des Operations Research, dann die etwas ausführlichere Beschreibung und schließlich Zahlenbeispiele anhand einer einfachen, oberflächenspezifisch orientierten Aufgabe.

2) Einordnung der Methode

Bei der Bewertung von Vorschlägen zur Prozeß- oder Produktverbesserung werden in Projektbesprechungen häufig ad hoc-Tabellen benutzt: einzelnen Ideen werden augenfällig "Gewichte" (Kreuze, Plus- oder Minuszeichen, seltener Balken entsprechender Höhe) zuordnet. Zum Beispiel kann ein Vorschlag A drei Pluszeichen, die Vorschläge B, C, ..., N entsprechend mehr oder weniger bekommen; "gewonnen" hat der Vorschlag, welcher schließlich die meisten Pluszeichen als Netto-Ergebnis auf sich vereinigt; in der außen rechts gelegenen Spalte der Tabelle in Abb. 1 ist dies Vorschlag A. Gelegentlich reichen schon Plausibilitätsüberlegungen, die Anzahl solcher Plus-/Minus-Prädikate für ein bestimmtes Konzept A relativ zu anderen Ideen festzulegen.So einfach und in der aktuellen Situation reizvoll diese Vorgehensweise ist, eignet sie sich doch höchstens dazu, Entscheidungen mit kurzfristiger Bedeutung oder Wirkung vorzubereiten, etwa für die Beurteilung des Erfolgs geringfügiger Veränderungen an bestehenden Prozessen oder Produkten. Bei mittel- oder langfristig angelegten Neuerungen oder gar bei der Beurteilung von Konkurrenzprodukten können sich hinter solchen bildlichen Zuweisungen emotional oder interessengelenkte Präferenzen verbergen, welche das Bewertungsergebnis und die Richtigkeit der schließlich getroffenen Entscheidung infrage stellen.

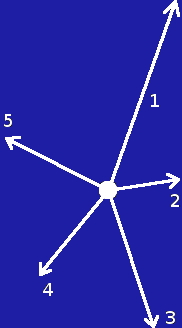

Etwas näher an objektiv begründeten Prognosen liegen "Spider"-Diagrammen: das sind genau genommen partielle Ableitungen von Funktionen nach einzelnen Variablen, indem man abzählt, wie eine ins Auge gefasste Gesamt-Maßnahme (Produktverbesserung, z. B. mit der obigen Idee A) von einzelnen Parametern (Einzelmaßnahmen) abhängt. Die Bedeutung der Parameter wird mit der Länge von Strahlen um ein Zentrum herum als "Spinne" veranschaulicht. Seien dies beispielsweise 5 Parameter, so zeigt Abb. 1 (unten), daß erwartet wird, das Ergebnis (erfolgreiche Verwirklichung von Idee A) hänge funktional am meisten vom Parameter Nr. 1 ab. Das Gesamtproblem wird damit aber nur unvollkommen abgebildet, weil zum einen mit der Länge der Pfeile noch nicht das Gewicht erfaßt wird, mit dem Parameter 1 in das Gesamtergebnis eingeht, und zum anderen zwischen den Einzelmaßnahmen Korrelationen bestehen können (in Spider-Diagrammen müsste man die totalen Ableitungen von Funktionen benutzen, was "ad hoc" in einer Projektbesprechung und selbst in einem vor- oder nachmittäglichen "Brain storming" kaum möglich ist).

| Pro | Contra | Gesamt | |

|---|---|---|---|

| Idee A | +++ | - | ++ |

| Idee B | + | -- | - |

| Idee C | ++ | - | + |

| ... | |||

| ... | |||

| Idee N | + | -- | - |

Während ad hoc-Tabellen und Spider-Diagramme bestenfalls grobe Erwartungswerte für die Tendenz verschaffen, mit der sich Erfolg oder Misserfolg vorgesehener Verbesserungsmaßnahmen einstellen wird, zielen am anderen Ende der Skala von Optimierungsmaßnahmen die Methoden des Operations Research auf wirkliche Optimierung, in Sinn von Extremalwerten, den die das Problem beschreibenden Funktionen einnehmen und die erkannt werden müssen. Unter methodischen Aspekten stellen sie die Krönung von Bemühungen dar, eine optimale Lösung für die Verbesserung eines Produkts oder eines Prozesses oder eines kombinatorischen oder Transportproblems zu finden.

Zwischen diesen beiden extrem vereinfachenden (ad hoc-Tabellen, Spider-Diagramme) bzw. mathematisch sehr aufwendigen Arbeitsweisen (Operations Research) liegt das Feld der Tendenz- und Risikoanalyse, das sich der beurteilenden Statistik und Fehleranalyse bedient. Weiter mag man sich beispielsweise noch der Lagrangeschen Multiplikatoren bedienen, mit denen innere Abläufe den existierenden Rand- oder Zwangsbedingungen unterworfen werden; diese Methode zielt jedoch wieder auf Optimierung.

Der im folgenden erläuterte Ansatz vermeidet beide Extreme:

- einerseits ersetzt er die in vielen Fällen wenig aussagekräftigen ad hoc-Beurteilungen durch ein besser abgesichertes, weil streng an innerbetriebliche Erfahrung gekoppeltes Instrument,

- andererseits weist er den hohen rechnerischen Aufwand linearer oder nicht-linearer Optimierungen einer vergleichsweise selten auftretenden, konkreten Bedarfssituation zu, die anders nicht zu bewältigen wäre.

Schließlich: Sind ad hoc-Tabellen und in gewissem Umfang auch Spider-Diagramem als "spontanitäts-gefährdet" anzusehen, ist die Interprätation der Optimierungsergebnisse des Operations Research nicht selten eine Domäne ausschließlich der Fachspezialisten, mit entsprechender "Fremdbestimmung" der Methoden, Modelle und Resultate, die ohne eine Übersetzung in die betriebsrelevante Sprache der eigenen Mitarbeiter kaum überprüfbar ist.

Demgegenüber ist die hier vorgestellte Methode der Tendenz- und Risikoanalyse transparent auch für diejenigen, die im betrieblichen Ablauf von den Resultaten unmittelbar oder in beurteilender und lenkender Funktion betroffen sind, ohne sie sich tiefgehende mathematische Kenntnisse aneignen müssen, um die Ergebnisse zu verstehen und zu kontrollieren.

Als Mittelweg, als Schritt, der unbestritten nicht an die theoretischen Herausforderungen des Operations Research heranreicht (und dies auch nicht soll), stellt das hier vorgestellte Verfahren dennoch ein feines Entscheidungsinstrument bereit. Sein Vorzug liegt insbesondere in der engen Kopplung an betriebliche Erfahrung und Praxis und im unmittelbaren und schnellen Transfer der Ergebnisse im Unternehmen. Es eignet sich sowohl als alleinige Basis zur Vorhersage des Erfolgs von zu treffenden Maßnahmen als auch für einen effektiven Zwischenschritt, bevor eventuell eine Analyse etwa mit Operations Research-Methoden vorgenommen werden muß. Dieses Instrument kann als punktuell ausgerichtete, numerische physikalisch/ingenieurmäßige Modellierung den linearen/nichtlinearen oder Nichtgleichgewichts-Optimierungen vorangehen, sie vorbereiten - und im günstigsten Fall sogar überflüssig machen. Die Methode ist auch dazu geeignet, Korrelationen zwischen einzelnen Verfahrensschritten quantitativ zu erfassen.

3) Tendenz und Risiko

Es soll eine Qualität verbessert werden.

verbessert werden.  kann beispielsweise den Wirkungsgrad einer Maschine bezeichnen,

kann beispielsweise den Wirkungsgrad einer Maschine bezeichnen,  die Oberflächenqualität einer dekorativen Beschichtung in irgendeiner Hinsicht (Reflexionsvermögen, Härte, Korrosionsbeständigkeit) oder

die Oberflächenqualität einer dekorativen Beschichtung in irgendeiner Hinsicht (Reflexionsvermögen, Härte, Korrosionsbeständigkeit) oder  die kritische Stromdichte eines supraleitenden Materials.

die kritische Stromdichte eines supraleitenden Materials. Bleiben wir bei einer dekorativen Oberflächenbeschichtung. Das Projektziel soll lauten, auf einem metallischen Substrat (z. B. Al-Blech) eine Oberfläche zu präparieren, die in mehreren Farben (Spektralbereichen) ein maximales Reflexionsvermögen (Index r) hat.

Die Qualität

kann als Funktion (im einfachsten Fall als Summe) von Funktionen

kann als Funktion (im einfachsten Fall als Summe) von Funktionen  (1 ≤ j ≤ M) dargestellt werden, welche die Abhängigkeit des Reflexionsvermögens r von beliebig vielen (M) Material- und Oberflächeneigenschaften (Parametern)

(1 ≤ j ≤ M) dargestellt werden, welche die Abhängigkeit des Reflexionsvermögens r von beliebig vielen (M) Material- und Oberflächeneigenschaften (Parametern)  beschreiben. Für das hier zu erzielende hohe Reflexionsvermögen auf dem metallischen Substrat umfassen die

beschreiben. Für das hier zu erzielende hohe Reflexionsvermögen auf dem metallischen Substrat umfassen die  alle Eigenschaften, die nachweislich Einfluß auf den Glanz der Oberfläche nehmen: das sind zumindest Rauhigkeit der Bleche im Lieferzustandzustand, Tiefe einer Elektropolitur, erforderliche Schichtdicken einer Vorbeschichtung, Kosten der Vorbehandlung, Kosten des finalen Beschichtungsvorgangs selbst, Lagerung sowie Sorgfalt bei Handhabung und Montage der beschichteten Bleche, je nach Anwendung.

alle Eigenschaften, die nachweislich Einfluß auf den Glanz der Oberfläche nehmen: das sind zumindest Rauhigkeit der Bleche im Lieferzustandzustand, Tiefe einer Elektropolitur, erforderliche Schichtdicken einer Vorbeschichtung, Kosten der Vorbehandlung, Kosten des finalen Beschichtungsvorgangs selbst, Lagerung sowie Sorgfalt bei Handhabung und Montage der beschichteten Bleche, je nach Anwendung.Jedes der

erstreckt sich über eine bestimmte Qualitätsspanne

erstreckt sich über eine bestimmte Qualitätsspanne  . Für die Qualitätsspannen sind Funktionen zu finden, die sagen, wie groß die Qualitätsunterschiede (z. B. Rauhigkeiten) von gelieferten Blechen von irgendeinem Hersteller sein können. Diese Funktionen können aus eigenen Erfahrungen mit den Herstellern stammen (wie stark variiert die Rauhigkeit von auf dem Markt erhältlichen Blechen? Welche Qualitätsunterschiede habe ich bei einem bestimmten Lieferanten zu erwarten?). Eventuell existiert sogar innerbetriebliche Statistik, die angibt, wie groß die Wahrscheinlichkeit ist, von diesem oder jenem Lieferanten ein unerwünscht raues Al-Blech zu erhalten, obwohl man doch sehr glattes Blech bestellt hatte.

. Für die Qualitätsspannen sind Funktionen zu finden, die sagen, wie groß die Qualitätsunterschiede (z. B. Rauhigkeiten) von gelieferten Blechen von irgendeinem Hersteller sein können. Diese Funktionen können aus eigenen Erfahrungen mit den Herstellern stammen (wie stark variiert die Rauhigkeit von auf dem Markt erhältlichen Blechen? Welche Qualitätsunterschiede habe ich bei einem bestimmten Lieferanten zu erwarten?). Eventuell existiert sogar innerbetriebliche Statistik, die angibt, wie groß die Wahrscheinlichkeit ist, von diesem oder jenem Lieferanten ein unerwünscht raues Al-Blech zu erhalten, obwohl man doch sehr glattes Blech bestellt hatte.Die Spannen

beschreiben demnach Unsicherheiten, mit denen hinsichtlich Rauhigkeit oder anderer Parameter bei Verwendung von Al-Blechen oder sonstigen metallischen Substraten zu rechnen ist. Sie eignen sich, wie in den Zahlenbeispielen erläutert wird, zur Berechnung des Entscheidungs-, Entwicklung- oder Prozeßrisikos, das im vorliegenden Beispiel nur aus der unerwünschten Schwankung des Rauhigkeitsmaßes resultiert; andere Schwankungen (Unsicherheiten) sind in einer vollständigen Beschreibung zu berücksichtigen.

beschreiben demnach Unsicherheiten, mit denen hinsichtlich Rauhigkeit oder anderer Parameter bei Verwendung von Al-Blechen oder sonstigen metallischen Substraten zu rechnen ist. Sie eignen sich, wie in den Zahlenbeispielen erläutert wird, zur Berechnung des Entscheidungs-, Entwicklung- oder Prozeßrisikos, das im vorliegenden Beispiel nur aus der unerwünschten Schwankung des Rauhigkeitsmaßes resultiert; andere Schwankungen (Unsicherheiten) sind in einer vollständigen Beschreibung zu berücksichtigen.Wie stark gehen die Schwankungen

in das Ergebnis "Reflexionsvermögen" ein? Ist mein Produkt von solchen Schwankungen überhaupt abhängig?

in das Ergebnis "Reflexionsvermögen" ein? Ist mein Produkt von solchen Schwankungen überhaupt abhängig?Bleiben wir beim Beispiel Al-Blech und Reflexionsvermögen. Daß hier das Rauhigkeitsmaß eine entscheidende Rolle dabei spielt, ob ein hohes Reflexionsvermögen mit der vorhandenen Beschichtungsanlage überhaupt erzielt werden kann, ist allgemein bekannt. Um zu berechnen, wie stark die Spannen

in die Tendenz

in die Tendenz  eingehen bzw. wie groß die Unsicherheit

eingehen bzw. wie groß die Unsicherheit  um die angestrebte und schließlich erzielte Qualität

um die angestrebte und schließlich erzielte Qualität  (hohes Reflexionsvermögen) herum sein wird, müssen die Spannen

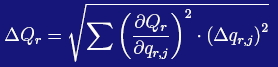

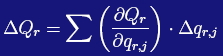

(hohes Reflexionsvermögen) herum sein wird, müssen die Spannen  mit Gewichten belegt werden. Analog zur Fehlerfortpflanzung haben wir, mit Summation über 1 ≤ j ≤ M

mit Gewichten belegt werden. Analog zur Fehlerfortpflanzung haben wir, mit Summation über 1 ≤ j ≤ M

|

(1a) |

zu bilden. In Gl. (1a) werden die Gewichte durch die partiellen Ableitungen

der Qualität

der Qualität  nach den

nach den  erhalten.

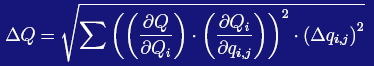

erhalten.Im konkreten Fall wird aber nicht nur das Reflexionsvermögen interessant sein, sondern auch eine "Gesamtqualität"

der Oberfläche, die neben dem hohem Reflexionsvermögen z. B. auch Teilqualitäten

der Oberfläche, die neben dem hohem Reflexionsvermögen z. B. auch Teilqualitäten  wie Lebensdauer oder Korrosionsstabilität umfassen kann. Wenn also statt der Unsicherheit der einen Teilqualität

wie Lebensdauer oder Korrosionsstabilität umfassen kann. Wenn also statt der Unsicherheit der einen Teilqualität  (des Reflexionsvermögens r) die Unsicherheit der Gesamtqualität

(des Reflexionsvermögens r) die Unsicherheit der Gesamtqualität  (Reflexionsvermögen und Lebensdauer) ermittelt werden soll, die von der Unsicherheit mehrerer (beispielsweise N) Teilqualitäten

(Reflexionsvermögen und Lebensdauer) ermittelt werden soll, die von der Unsicherheit mehrerer (beispielsweise N) Teilqualitäten  abhängen kann, worin jedes

abhängen kann, worin jedes  (wie

(wie  ) eine Funktion von

) eine Funktion von  Parametern

Parametern  ist, muß Gl. (1a) erweitert werden: Mit 1 ≤ i ≤ N und 1 ≤ j ≤

ist, muß Gl. (1a) erweitert werden: Mit 1 ≤ i ≤ N und 1 ≤ j ≤  ist die Summe über i und j zu bilden

ist die Summe über i und j zu bilden

|

(1b) |

(hierin wurde der Index r des Reflexionsvermögens durch den Index i ersetzt, was bedeutet, daß r nun ein Index unter einer Reihe anderen Indices 1 ≤ i ≤ N ist).

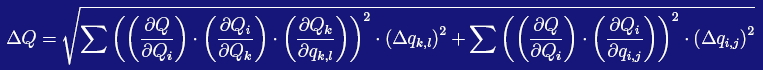

Wenn darüber hinaus einige der

untereinander korreliert sind, ist Gl. (1a) nochmals zu ergänzen: hohe Reflexionsvermögen zu erzielen ist teuer. Es gibt daher auch einen Zusammenhang zwischen dem angestrebten Reflexionsvermögen, i = r, und den Kosten, k, die dafür aufgewendet werden müssen. Ebenso werden andere Teilqualitäten

untereinander korreliert sind, ist Gl. (1a) nochmals zu ergänzen: hohe Reflexionsvermögen zu erzielen ist teuer. Es gibt daher auch einen Zusammenhang zwischen dem angestrebten Reflexionsvermögen, i = r, und den Kosten, k, die dafür aufgewendet werden müssen. Ebenso werden andere Teilqualitäten  (wie die schon genannte Lebensdauer und die Korrosionsstabilität) von Kosten abhängen. Diese Abhängigkeiten seien für jede Teilqualität durch Funktionen

(wie die schon genannte Lebensdauer und die Korrosionsstabilität) von Kosten abhängen. Diese Abhängigkeiten seien für jede Teilqualität durch Funktionen  =

=  (

( ) mit (1 ≤ k ≤ K) dargestellt, die ihrerseits von Parametern

) mit (1 ≤ k ≤ K) dargestellt, die ihrerseits von Parametern  (1 ≤ l ≤ L) abhängen werden (mit den Indices l können z. B. die Kosten in verschiedenen Fertigungsschritten erfaßt werden). Dann ist mit Summe über i, k und l sowie über i und j zu bilden, wieder mit 1 ≤ i ≤ N und 1 ≤ j ≤

(1 ≤ l ≤ L) abhängen werden (mit den Indices l können z. B. die Kosten in verschiedenen Fertigungsschritten erfaßt werden). Dann ist mit Summe über i, k und l sowie über i und j zu bilden, wieder mit 1 ≤ i ≤ N und 1 ≤ j ≤  ,

,

|

(1c) |

Gehen wir zur Vereinfachung zu Gl. (1a) zurück und betrachten nur das Reflexionsvermögen (reduzieren also den Wertebereich des Index i auf lediglich i = r) als Funktion der Parameter 1 ≤ j ≤ M (M entsprechend ohne Index i). Wir untersuchen z. B. den Einfluß von Rauhigkeitsmaß und Lagerbedingungen vor und nach der Beschichtung. Damit ist M = 3.

Zusammengefaßt muß man dann mit Gleichung (1a) folgende Fragen diskutieren:

- Wie stark gehen Rauhigkeit (j = 1) oder Lagerbedingungen vor (j = 2) und nach der Beschichtung (j = 3) grundsätzlich in das Gesamtergebnis

(Reflexionsvermögen) ein? Die Antwort muß in einer Modellierung gefunden und in die

(Reflexionsvermögen) ein? Die Antwort muß in einer Modellierung gefunden und in die  gesteckt werden.

gesteckt werden. - Wie stark verschieden sind die Rauhigkeiten auf den angelieferten Blechen? Die Antwort hierauf liefern die betrieblich bekannten

.

. - Wie groß ist die Gesamt-Unsicherheit (das Risiko), mit der gerechnet werden muß, wenn auf Al-Blechen und mit Standard-Lagerungsbedingungen der Bleche vor und nach dem Beschichten ein hohes Reflexionsvermögen erzielt werden soll? Diese Angabe liefert schließlich die Größe

.

.

Entsprechend erweitert sich die Modellierung, wenn nicht nur das Reflexionsvermögen sondern auch andere Teilqualitäten (Kosten, wirtschaftliches Potential, Lebensdauer der Schichten, Korrosionsstabilität) oder eine Korrelation in die Analyse einbezogen werden sollen; dann muß man mit den gegenüber Gl. (1a) erweiterten Gleichungen (1b) und (1c) rechnen.

Das Ergebnis

gibt also an, mit welchem Risiko eine Entscheidung getroffen bzw. ein ins Auge gefasster Teilprozeß belastet wird bzw. wie hoch das Risiko

gibt also an, mit welchem Risiko eine Entscheidung getroffen bzw. ein ins Auge gefasster Teilprozeß belastet wird bzw. wie hoch das Risiko  für das Gesamtprojekt unter Einschluß auch von Lebensdauer, Kostensituation oder einer Korrelation ausfällt.

für das Gesamtprojekt unter Einschluß auch von Lebensdauer, Kostensituation oder einer Korrelation ausfällt.Zu beantworten ist aber auch die Frage: gibt es denn überhaupt eine positive Tendenz

für den Projekterfolg, nämlich ein hohes Reflexionsvermögen? Bisher haben wir ja nur die Unsicherheiten um die (hoffentlich positive) Tendenz herum abgeschätzt. Die Abschätzung für die Tendenz

für den Projekterfolg, nämlich ein hohes Reflexionsvermögen? Bisher haben wir ja nur die Unsicherheiten um die (hoffentlich positive) Tendenz herum abgeschätzt. Die Abschätzung für die Tendenz  ist in der sogleich folgenden Gl. (3a) enthalten.

ist in der sogleich folgenden Gl. (3a) enthalten.Um die Darstellung zu vereinfachen, werden wir zuvor jedoch einige Vereinbarungen treffen, welche die Gültigkeit und Anwendbarkeit der Methode nicht einschränken:

a) Wir beschränken uns auf das Teilproblem "hohes Reflexionsvermögen" (Gl. 1a) mit den Parametern Rauhigkeitsmaß und Lagerbedingungen vor und nach dem Beschichten, klammern den eigentlichen Beschichtungsvorgang jedoch aus, um die Vorstellung der Methode zu vereinfachen (beim Beschichtungsvorgang müßte man einige Teilqualitäten hinzunehmen; darauf wollen wir verzichten).

b) Wir rechnen in Gl. (1a) nicht mit quadratischen Termen (wie bei der Fehlerfortpflanzung) sondern approximieren die totalen Differentiale in dieser Gleichung mit der einfachen Summenformel

|

(2a) |

mit Summation über 1 ≤ j ≤ 3, um Nachrechnen von einigen Beispielen zu erleichtern. Entsprechende Vereinbarungen könnten wir für Gl. (1b) und (1c) treffen.

c) Wir wählen aus den Spannen

einen Wert

einen Wert  aus, den wir realistisch bekommen bzw. erzielen können. Wenn wir die

aus, den wir realistisch bekommen bzw. erzielen können. Wenn wir die  in Gl. (1a) jeweils durch diesen festen Wert,

in Gl. (1a) jeweils durch diesen festen Wert,  ersetzen (wobei wieder die obige Vereinbarung (b) gelten soll) zeigt

ersetzen (wobei wieder die obige Vereinbarung (b) gelten soll) zeigt

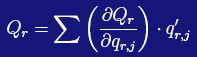

|

(3a) |

die gesuchte Tendenz auf, mit der wir bei einer Auswahl aus verschiedenen Materialien, Lagerungsbedingungen oder unter Kostensituationen ein Ergebnis in Richtung Erfolg oder Nichterfolg erwarten dürfen.

Mit diesen Vereinbarungen sind für die Aufstellung von Gl. (3a) folgende Fragen aus betrieblichen Erfahrungen zu beantworten:

- Welche Rauhigkeitsmaße können aus dem Angebot verschiedener Lieferanten von Blechen realistisch erwartet werden?

- Unter welchen Lagerungsbedingungen werden die Bleche vor und nach der Beschichtung bevorratet? Dies sind die

.

.

Gl. (3a) liefert das Ergebnis auf die Frage:

- Welche Tendenz in Richtung Erfolg oder Mißerfolg kann erwartet werden, wenn auf der Basis dieser Rauhigkeitsmaße und Lagerbedingungen eine Entscheidung gefällt bzw. ein Prozeß durchgeführt wird?

Die Antwort steckt in der Größe

.

.Für das Beispiel "hohes Reflexionsvermögen" geht man so vor: alle Materialien oder Maßnahmen, die das Reflexionsvermögen vergrößern, sollen mit positiven

bezeichnet werden. Je positiver (in diesem Beispiel) die

bezeichnet werden. Je positiver (in diesem Beispiel) die  sind, und je stärker sie ihrer Bedeutung nach mit den

sind, und je stärker sie ihrer Bedeutung nach mit den  gewichtet werden, umso größer ist

gewichtet werden, umso größer ist  und umso größer ist die Aussichten, die richtige Entscheidung getroffen zu haben, um den Prozeßerfolg zu erzielen.

und umso größer ist die Aussichten, die richtige Entscheidung getroffen zu haben, um den Prozeßerfolg zu erzielen.Umgekehrt wird in diesem Beispiel eine zu große Rauhigkeit als negative Größe in Gl. (3a) eingegeben (wir wollen das Reflexionsvermögen ja nicht verringern, daher die Zuweisung negativer

). Den Betrag von

). Den Betrag von  kann man z. B. durch die Abweichung von einem geforderten (kleinen) Rauhigkeitsmaß der Bleche festsetzen, ebenso eine hohe Staubbelastung der Lageratmosphäre, wenn sie von einem geforderten schärferen Reinraumkriterium abweichen sollte.

kann man z. B. durch die Abweichung von einem geforderten (kleinen) Rauhigkeitsmaß der Bleche festsetzen, ebenso eine hohe Staubbelastung der Lageratmosphäre, wenn sie von einem geforderten schärferen Reinraumkriterium abweichen sollte.Wenn wir den

wegen verfügbarer Lieferqualitäten, Lagerbedingungen oder Beschichtungsverfahren ausschließlich negative Werte

wegen verfügbarer Lieferqualitäten, Lagerbedingungen oder Beschichtungsverfahren ausschließlich negative Werte  zuweisen müßten, wäre eine Erhöhung des Reflexionsvermögens grundsätzlich nicht möglich; Mischungen von positiven und negativen

zuweisen müßten, wäre eine Erhöhung des Reflexionsvermögens grundsätzlich nicht möglich; Mischungen von positiven und negativen  können in Einzelfällen jedoch zum Erfolg führen.

können in Einzelfällen jedoch zum Erfolg führen.Wie schon erwähnt kann in einem Spektralbereich 1 der Einfluß der Rauhigkeit auf das Reflexionsvermögen kleiner sein als in einem Spektralbereich 2 (in der Tat ist der Einfluß der Rauhigkeit auf das Reflexionsvermögen bei großen Wellenlängen geringer als bei kleinen). Dies wäre durch entsprechende

und

und  zu berücksichtigen.

zu berücksichtigen.Wenn die Gewichte

oder die Spannen

oder die Spannen  nicht hinreichend genau bekannt sind, um sie als analytische (differenzierbare) Funktionen quantitativ darzustellen, wird es in einigen Fällen ausreichen, sie als reelle oder natürliche Zahlen bzw. als Intervalle solcher Zahlen anzugeben. In diesem einfachsten Fall sind

nicht hinreichend genau bekannt sind, um sie als analytische (differenzierbare) Funktionen quantitativ darzustellen, wird es in einigen Fällen ausreichen, sie als reelle oder natürliche Zahlen bzw. als Intervalle solcher Zahlen anzugeben. In diesem einfachsten Fall sind  und

und  dimensionslose Größen.

dimensionslose Größen.4) Zahlenbeispiel

Für j = 1 soll die Rauhigkeit der Bleche, die sehr verschieden ausfallen kann, das Intervall -6 ≤ ≤ 6 überstreichen, für j = 2 die Lagerungsbedingungen vor der Oberflächenbeschichtung das Intervall -2 ≤

≤ 6 überstreichen, für j = 2 die Lagerungsbedingungen vor der Oberflächenbeschichtung das Intervall -2 ≤  ≤ 0, sowie schließlich für j = 3 die Lagerungsbedingungen nach der Beschichtung das Intervall -4 ≤

≤ 0, sowie schließlich für j = 3 die Lagerungsbedingungen nach der Beschichtung das Intervall -4 ≤  ≤ 0. Dies sind maximale Spreizungen, die den gesamten Bereich zwischen "als schlechteste Lösung verwerfen" und "als beste Lösung zulassen" definieren. Sie resultieren z. B. aus dem Datenbereich, in dem die Abhängigkeit des Reflexionsvermögens von der Rauhigkeit gesichert ist, aus Diagrammen oder Tabellen in der Literatur, die man durch Funktionen

≤ 0. Dies sind maximale Spreizungen, die den gesamten Bereich zwischen "als schlechteste Lösung verwerfen" und "als beste Lösung zulassen" definieren. Sie resultieren z. B. aus dem Datenbereich, in dem die Abhängigkeit des Reflexionsvermögens von der Rauhigkeit gesichert ist, aus Diagrammen oder Tabellen in der Literatur, die man durch Funktionen  approximieren kann; dieser Bereich ist eventuell viel größer als derjenige, den wir zulassen dürfen, um das Projektziel nicht zu gefährden. Tatsächliche (für das Projektziel akzeptable) Spreizungen liegen dazwischen, je nachdem, wie Zuliefererqualität und eigene Lagerbedingungen ausfallen.

approximieren kann; dieser Bereich ist eventuell viel größer als derjenige, den wir zulassen dürfen, um das Projektziel nicht zu gefährden. Tatsächliche (für das Projektziel akzeptable) Spreizungen liegen dazwischen, je nachdem, wie Zuliefererqualität und eigene Lagerbedingungen ausfallen.Zunächst Anmerkungen zu den oben angegebenen maximalen Spreizungen, die nach Möglichkeit funktional angegeben werden sollten:

Mit einem positiven Einfluß der Lagerungsatmosphäre auf das (spätere) Reflexionsvermögen der Bleche vor der Beschichtung ist kaum zu rechnen; dort geht es vielmehr darum, die gelieferte Oberflächenqualität zu erhalten, gegebenenfalls darauf zu achten, dass sie nicht noch weiter zu verschlechtert wird. Daher wird die obere Grenze auf

= 0 festgesetzt. Ein negativer Einfluß wäre in korrosiver Lageratmosphäre oder bei völlig unsachgemäßer Handhabung zu erwarten, welche die gelieferte Oberflächenqualität schon vor der Beschichtung beeinträchtigen würde; dies dürfte in der Praxis von Beschichtungsunternehmen jedoch kaum vorkommen. Um diese Möglichkeit letztlich nicht auszuschließen, wird für die untere Grenze von

= 0 festgesetzt. Ein negativer Einfluß wäre in korrosiver Lageratmosphäre oder bei völlig unsachgemäßer Handhabung zu erwarten, welche die gelieferte Oberflächenqualität schon vor der Beschichtung beeinträchtigen würde; dies dürfte in der Praxis von Beschichtungsunternehmen jedoch kaum vorkommen. Um diese Möglichkeit letztlich nicht auszuschließen, wird für die untere Grenze von  der Wert -1 angenommen.

der Wert -1 angenommen.Dagegen wird nach der Beschichtung eine staubige Lageratmosphäre oder eine unangemessene Handhabung der Bleche das Reflexionsvermögen ziemlich sicher herabsetzen; deswegen wird hier als untere Grenze der Spreizung

der Wert -4 ≤

der Wert -4 ≤  festgelegt, die obere Grenze wie zuvor auf Null.

festgelegt, die obere Grenze wie zuvor auf Null.Generell ist die Spreizung der

oder der

oder der  hinsichtlich Standard-Lagerungsbedingungen vor oder nach Beschichtdung geringer als diejenige bezüglich Rauhigkeit.

hinsichtlich Standard-Lagerungsbedingungen vor oder nach Beschichtdung geringer als diejenige bezüglich Rauhigkeit.Die tatsächlichen Spreizungen, die wir aus der Vielfalt der maximalen Spreizungen zulassen dürfen, sollen zunächst für die Rauhigkeit (Index j = 1) durch das Intervall -2 ≤

≤ 6, für die Lagerungsbedingungen vor der Oberflächenbeschichtung (Index j = 2) mit dem Intervall -1 ≤

≤ 6, für die Lagerungsbedingungen vor der Oberflächenbeschichtung (Index j = 2) mit dem Intervall -1 ≤  ≤ 0, sowie schließlich für die Lagerungsbedingungen nach der Beschichtung (Index j = 3) mit dem Intervall -2 ≤

≤ 0, sowie schließlich für die Lagerungsbedingungen nach der Beschichtung (Index j = 3) mit dem Intervall -2 ≤  ≤ 0 festgelegt sein (wir werden später sehen, daß wir schärfere Kriterien, also geringere Spreizungen, fordern müssen, um erfolgreich zu sein).

≤ 0 festgelegt sein (wir werden später sehen, daß wir schärfere Kriterien, also geringere Spreizungen, fordern müssen, um erfolgreich zu sein).Ebenso vergeben wir zur Vereinfachung im vorliegenden Beispiel natürliche Zahlen für die Gewichte

(um exakt zu sein, müßten sie wie oben dargestellt aus differenzierbaren Funktionen

(um exakt zu sein, müßten sie wie oben dargestellt aus differenzierbaren Funktionen  berechnet werden; hierauf wird in den Zahlenbeispielen verzichtet). Dazu sei angenommen, daß der Einfluß der Rauhigkeit auf das Endergebnis

berechnet werden; hierauf wird in den Zahlenbeispielen verzichtet). Dazu sei angenommen, daß der Einfluß der Rauhigkeit auf das Endergebnis  dreimal größer ist als derjenige der Lagerbedingungen vor dem Beschichten, also

dreimal größer ist als derjenige der Lagerbedingungen vor dem Beschichten, also  = 3,

= 3,  = 1. Da das (hohe) Reflexionsvermögen der Bleche nach dem Beschichten empfindlich auf Verunreinigungen aller Art reagiert, wird als zugehöriges Gewicht hier

= 1. Da das (hohe) Reflexionsvermögen der Bleche nach dem Beschichten empfindlich auf Verunreinigungen aller Art reagiert, wird als zugehöriges Gewicht hier  = 2 gewählt.

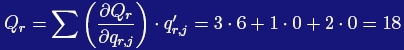

= 2 gewählt.Haben wir optimale, d. h. optisch glatte Bleche sicher zur Verfügung und sind auch unsere Lagerbedingungen sicher optimal, nehmen

,

,  und

und  die jeweils höchsten Werte (6, 0 und 0) an. Dies ergibt mit Gl. (3a) und 1 ≤ j ≤ 3 die maximal mögliche, positive Tendenz

die jeweils höchsten Werte (6, 0 und 0) an. Dies ergibt mit Gl. (3a) und 1 ≤ j ≤ 3 die maximal mögliche, positive Tendenz

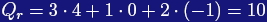

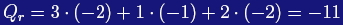

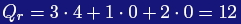

|

(4a) |

als Extremfall bester Einkaufs- und Lagerungsbedingungen.

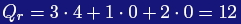

Können wir statt optisch glatter Bleche nur solche mit etwas größerem Rauhigkeitsmaß, beschrieben mit z. B.

= 4 beschaffen, wogegen die Lagerungsbedingungen weiterhin optimal sein sollen, haben wir erneut eine positive Tendenz, nämlich

= 4 beschaffen, wogegen die Lagerungsbedingungen weiterhin optimal sein sollen, haben wir erneut eine positive Tendenz, nämlich

|

(4b) |

Sind gegenüber Gl. (4b) die Lagerbedingungen nach dem Beschichten ungünstiger, müssen wir in der gleichen Spanne den Wert

von Null auf beispielsweise

von Null auf beispielsweise  = -1 reduzieren. Dies ergibt

= -1 reduzieren. Dies ergibt

|

(4c) |

Alle drei Tendenzen sind positiv, weil wir in Gl. (4a) alle Parameter

optimistisch "auf der positiven Seite", in Gl. (4b) die Rauhigkeit etwas weniger vorteilhaft, jedoch die Lagerbedingungen weiterhin optimistisch und in Gl. (4c) die Rauhigkeit etwas weniger vorteilhaft und dazu die etwas schlechteren Lagerungsbedingungen nach dem Beschichten gewählt haben. In allen drei Fällen erwarten wir eine Tendenz zum Projekterfolg hin, wenn wir von irgendeiner dieser Optionen bezüglich Rauhigkeitsmaß und Lagerbedingungen ausgehen.

optimistisch "auf der positiven Seite", in Gl. (4b) die Rauhigkeit etwas weniger vorteilhaft, jedoch die Lagerbedingungen weiterhin optimistisch und in Gl. (4c) die Rauhigkeit etwas weniger vorteilhaft und dazu die etwas schlechteren Lagerungsbedingungen nach dem Beschichten gewählt haben. In allen drei Fällen erwarten wir eine Tendenz zum Projekterfolg hin, wenn wir von irgendeiner dieser Optionen bezüglich Rauhigkeitsmaß und Lagerbedingungen ausgehen.Nun jedoch zum Entscheidungs- oder Prozeßrisiko für diese drei Tendenzen. Dazu müssen wir die oben angegebenen tatsächlichen (zulässigen) Spreizungen

verwenden. Wenn am minimaler Rauhigkeit festgehalten wird (

verwenden. Wenn am minimaler Rauhigkeit festgehalten wird ( = 6), beläuft sich

= 6), beläuft sich  ausgehend von Gl. (2a) "nach unten" gezählt auf

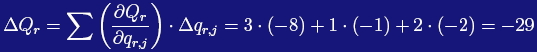

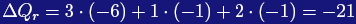

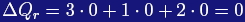

ausgehend von Gl. (2a) "nach unten" gezählt auf

|

(5a) |

Nach "oben gezählt" ist

= 0, da wir ja nicht besser als werden können, als die optimalen Werte aus der maximalen Spreizung dies schon zulassen.

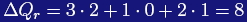

= 0, da wir ja nicht besser als werden können, als die optimalen Werte aus der maximalen Spreizung dies schon zulassen.Wird in Gl. (2a) statt dessen mit den Annahmen für Gl. (4b) "nach unten"> gezählt, haben wir mit

= 4 und weiterhin optimalen Lagerungsbedingungen

= 4 und weiterhin optimalen Lagerungsbedingungen

|

(5b) |

und bei Zählung "nach oben"

|

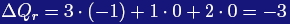

Im dritten Fall wird mit den Annahmen für Gl. (4c) mit

= 4, optimalen Lagerungsbedingungen vor (

= 4, optimalen Lagerungsbedingungen vor ( = 0), jedoch etwas geringerer Lagerungsbedingung nach der Beschichtung (

= 0), jedoch etwas geringerer Lagerungsbedingung nach der Beschichtung ( = -1), nach "unten gezählt"

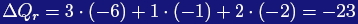

= -1), nach "unten gezählt"

|

(5c) |

und nach "oben gezählt"

|

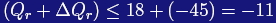

Da in allen drei Fällen das Risiko

"nach unten" (Gl. 5,a,b,c) dem Betrag nach größer ist als der Absolutwert der entsprechenden Tendenzen

"nach unten" (Gl. 5,a,b,c) dem Betrag nach größer ist als der Absolutwert der entsprechenden Tendenzen  , (Gl. 4a,b,c) kann selbst mit dem größten

, (Gl. 4a,b,c) kann selbst mit dem größten  aus Gl. (4a) ein negatives Ergebnis (Reflexionsvermögen zu niedrig) nicht ausgeschlossen werden, nämlich nach Gl. (4a) und (5a)

aus Gl. (4a) ein negatives Ergebnis (Reflexionsvermögen zu niedrig) nicht ausgeschlossen werden, nämlich nach Gl. (4a) und (5a)

|

Daher wird man kleinere Spreizungen als die oben verwendeten fordern müssen; hierauf wird sogleich eingegangen. Zuvor noch zur Illustration der gegenüber Gl. (4a) negative Extremfall:

Haben nämlich die Bleche katastrophal große Rauhigkeit, und sind auch die Lagerbedingungen sehr schlecht (d. h. liegen die

,

,  und

und  an den unteren Grenzen der maximalen Spreizungen), ergibt sich in diesem schlimmsten Fall für

an den unteren Grenzen der maximalen Spreizungen), ergibt sich in diesem schlimmsten Fall für  eine negative Tendenz

eine negative Tendenz

|

(4d) |

(und nicht erst in

+

+  eine negative Zahl). Ein negatives Ergebnis resultiert auch mit den zuvor genannten unteren Grenzen der zulässigen Spreizungen,

eine negative Zahl). Ein negatives Ergebnis resultiert auch mit den zuvor genannten unteren Grenzen der zulässigen Spreizungen,

|

da der Term 3*(-2) durch die Lagerungsbedingungen nicht kompensiert werden kann.

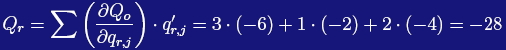

Bei der Zählung "nach unten" wird im Extremfall

|

(5d) |

so daß

Schlechter als die Tendenz

= -28 geht es ja nicht; das Risiko, noch schlechter zu werden, ist daher Null. Für die Zählung "nach oben" gelten enge Spreizungen, da auf verdreckten Blechen keine hohe Reflexionsvermögen herbeigezaubert werden können. Nehmen wir in diesem Fall für alle Spreizungen (1 ≤j ≤3) maximal

= -28 geht es ja nicht; das Risiko, noch schlechter zu werden, ist daher Null. Für die Zählung "nach oben" gelten enge Spreizungen, da auf verdreckten Blechen keine hohe Reflexionsvermögen herbeigezaubert werden können. Nehmen wir in diesem Fall für alle Spreizungen (1 ≤j ≤3) maximal  = ±1 an, bleibt das Ergebnis (

= ±1 an, bleibt das Ergebnis ( +

+  ) auch bei Zählung "nach oben" negativ.

) auch bei Zählung "nach oben" negativ. Offensichtlich müssen die oben genannten zulässigen Spreizungen eingeschränkt werden. Es sind Lieferanten zu finden, die nur hochwertige Bleche, mindestens mit

= 4 liefern und die eine kleinere Qualitätsspanne

= 4 liefern und die eine kleinere Qualitätsspanne  bezüglich Rauhigkeit ihrer Bleche garantieren können, etwa

bezüglich Rauhigkeit ihrer Bleche garantieren können, etwa  = ±1. Weiter wollen wir sicher gehen, daß unsere Lagerbedingungen vorzüglich sind, damit vor und nach der Beschichtung

= ±1. Weiter wollen wir sicher gehen, daß unsere Lagerbedingungen vorzüglich sind, damit vor und nach der Beschichtung  =

=  = 0 gilt. Wegen der oberen Intervallgrenze Null hinsichtlich der Lagerungsbedingungen folgt daraus, daß die Spreizung für die Rauhigkeit keine negative untere Intervallgrenze haben darf.

= 0 gilt. Wegen der oberen Intervallgrenze Null hinsichtlich der Lagerungsbedingungen folgt daraus, daß die Spreizung für die Rauhigkeit keine negative untere Intervallgrenze haben darf.Mit diesen Vorgaben kommen negative

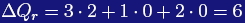

nicht mehr vor, so daß wir mit diesen Forderungen

nicht mehr vor, so daß wir mit diesen Forderungen  sowie bei Zählung "nach unten"

sowie bei Zählung "nach unten"  und bei Zählung "nach oben"

und bei Zählung "nach oben"  erhalten. Damit ist, gezählt "nach unten", auch

erhalten. Damit ist, gezählt "nach unten", auch  im positiven Bereich; das gleiche gilt für die Zählung "nach oben" mit

im positiven Bereich; das gleiche gilt für die Zählung "nach oben" mit  und

und  .

.Der Erwartungswert für das Ergebnis liegt somit im Intervall

|

(6) |

d. h. durchweg bei positiven Zahlen.

Eine Entscheidung, die auf diesen Rauhigkeits- und diesen Lagerbedingungen beruht (worin alle nur mit kleinen Unsicherheiten behaftet sind), wird zum Erfolg führen.

Der Teilprozeß "Auswahl der Bleche und der Lagerungsbedingungen" aus dem Gesamtvorhaben "Oberflächenbeschichtung für hohes Reflexionsvermögen" wird also auch jetzt noch erfolgreich sein, obwohl das Rauhigkeitsmaß in diesem Beispiel nicht mehr optimal klein ist (nämlich

= 4 statt 6).

= 4 statt 6).

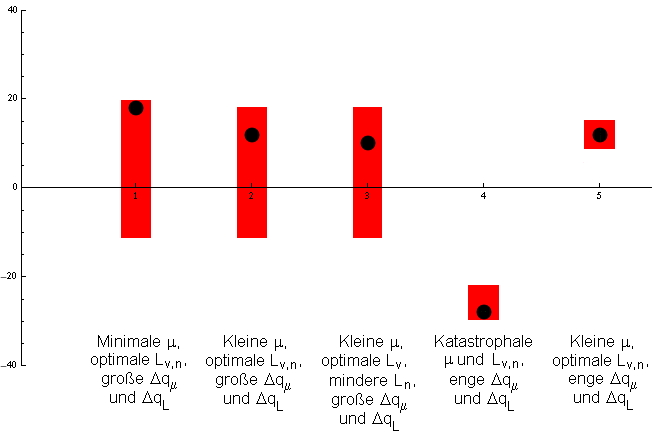

Abb. 2 zeigt die verschiedenen Tendenzen, Risiken und Erwartungswerte als Balkendiagramme für diese Beispiele mit den großen Spreizungen sowie die Ergebnisse für den Fall katastrophaler Vorgaben. Die oberen und unteren Intervallgrenzen der Erwartungswerte hinsichtlich sind gleich, unterschiedlich sind jedoch die Tendenzen, so daß unter diesen drei Optionen das Ergebnis nach Gl. (4a) mit den optimalen Vorgaben das günstigste sein könnte, wäre da nicht die stark negative Unsicherheit, welche einen Mißerfolg nicht ausschließt.

Mit den engeren Spreizungen erweist sich nach Gl. (6) mit dem in Abb. 2 ganz rechts liegenden Balken als sicherste Lösung des Problems in Richtung auf einen Prozeßerfolg: positive Tendenz und lediglich kleine Unsicherheiten hierin stehen dafür gerade.

Analog ist in anderen als den hier betrachteten Teilprozessen vorzugehen. Noch einmal sei darauf hingewiesen, daß die vorgestellten Berechnungen stark vereinfacht wurden, um leichtes Nachrechnen zu ermöglichen.

5) Das restliche Problem ist aber das schwierigste

Die vorgestellte Vorgehensweise ist rechnerisch vergleichsweise einfach zu handhaben, und wenn man die Näherung in Gl. (2a) und (3a) zugrunde legt, ist der verbleibende numerische Formalismus sogar trivial. Das schwierigere Problem steht jedoch noch bevor - aber da davon auch alle Optimierungsverfahren ohne Ausnahme betroffen sind, fügt es der hier beschriebenen Methode keine Schwierigkeit hinzu, auf welche andere Verfahren etwa nicht treffen würden:Es gilt nämlich, die

als analytische Funktionen zu formulieren, um die partiellen Ableitungen hieraus oder Näherungen hieran zu berechnen. Selbst wenn man sich auf die Vereinfachung nach Gl. (2a) und (3a) beschränkt, verlangt das Verfahren ein gehöriges Maß an Erfahrung und Abstraktionsvermögen, vorzugsweise in der physikalischen Modellierung, um zutreffende Bewertungen vorzunehmen.

als analytische Funktionen zu formulieren, um die partiellen Ableitungen hieraus oder Näherungen hieran zu berechnen. Selbst wenn man sich auf die Vereinfachung nach Gl. (2a) und (3a) beschränkt, verlangt das Verfahren ein gehöriges Maß an Erfahrung und Abstraktionsvermögen, vorzugsweise in der physikalischen Modellierung, um zutreffende Bewertungen vorzunehmen.An dieser Stelle setzt das Angebot ein, Sie, geehrter Leser, bei Ihrer Produkt- oder Prozeßverbesserung zu unterstützen. Wagen Sie einen ersten Versuch! Für die Anwendung des geschilderten Verfahrens liegen ja bereits positive Erfahrungen vor:

Das Verfahren wurde nämlich auf Verbesserungen angewendet wie Überlegungen "im Kleinen" hinsichtlich der Entwicklung neuer Oberflächen für Dampf- und Gasturbinen oder optimaler Strahlungsschirme bis hin zu Optimierungsaufgaben "im Großen" für ein emissionsarmes Kraftwerk. "Verbesserung" bedeutete dabei, neue Wege zu beurteilen, indem deren Tendenzen zum Erfolg und ihr Riskio aufgezeigt werden sollten. Entsprechend breit gestreut ist der Aufwand (Zeitraum, manpower), der investiert werden muß, wenn solche sehr verschiedenen Probleme angegangen werden. Für einfache Aufgaben wie Verbesserung von Strahlungsschirmen hat man ein verlässliches Ergebnis innerhalb weniger Tage, ein vorzüglich ausgelegtes Kraftwerk wird man nicht so schnell beschreiben können. Empfehlenswert ist in jedem Fall ein komponenten- bzw. schrittweise strukturiertes Vorgehen, gründliches Literaturstudium, mathematisch/numerisches Rüstzeug und breite Erfahrung bei der Modellierung betriebsinterner oder betriebsfremder Abläufe, um herauszufinden, welches Potential den eigenen Zielen jeweils zur Verfügung steht.

Generell ist in diese Vorgehensweise weniger Zeit und geringerer finanzieller Aufwand zu investieren als in klassische Methoden des Operations Research.

Das hier beschriebene Optimierungsverfahren kann Umweltbilanzen (siehe Life Cycle Assessment) einschließen. Es eignet sich ebenso zur Begründung von Entscheidungen, welche Produktmanagement, Kosten, Einsatz betrieblicher Mittel und sogar Anlagestrategien betreffen. Wie Life Cycle Assessment ist es sowohl ein effektives Design- als auch ein vielversprechendes Marketing-Instrument und in allem: ein einfaches und vorzügliches Werkzeug zur Qualitätssicherung.